In april 2023 werd het startschot gegeven voor een PoC-fase met zes deelnemende onderwijsinstellingen. SURF organiseerde een kick-off met zes deelnemende instellingen:

• Universiteit van Amsterdam

• Universiteit Twente

• Universiteit Utrecht

• Hogeschool Inholland

• Universiteit Leiden

• RoC-Amsterdam/Flevoland

Doel van de PoC

Het doel van de PoC was om te kijken of het technisch haalbaar en realistisch is om data vanuit die verschillende bronnen te ontsluiten, te transformeren indien nodig, en vervolgens te visualiseren in een generieke learning-analytics-omgeving.

Voor instellingen lag de meerwaarde van de PoC ook in het doorlopen van alle stappen om van data tot een dashboard te komen en het delen van ervaringen met andere instellingen:

“Bijdragen aan landelijke ontwikkelingen Learning Analytics en aan de ontwikkelingen rondom studiedata en Learning Analytics zodat data integratie bij nieuwe applicaties sneller gaat”.

“Van en met elkaar leren, meekijken naar wat er bij andere onderwijsinstellingen gebeurt en hoe we daarin ook kunnen groeien”.

“Zoals de PoC is opgezet bevat het alle fasen die we als instelling ook willen doorlopen. De opzet van de PoC doet dit sneller waarmee het ook intern een goed onderzoek is van wat we willen bereiken”.

Maandelijkse meetings

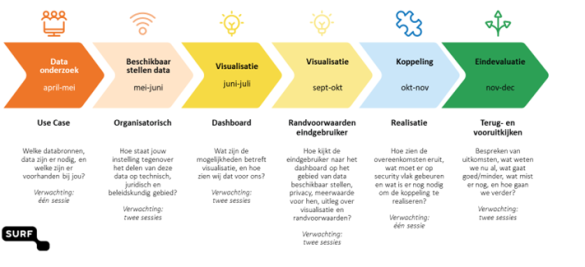

Tijdens maandelijkse meetings werd de voortgang van het project besproken. Deze gestructureerde bijeenkomsten dienden als een platform voor het delen van inzichten, het aanpakken van uitdagingen en het gezamenlijk streven naar de ontwikkeling en evaluatie van het student-facing dashboard.

Privacy

Een extra sessie werd gewijd aan het belangrijke aspect van privacy, wat bij verschillende instellingen een uitdagend onderwerp bleek te zijn in de PoC. Deze specifieke bijeenkomst bood de gelegenheid om gezamenlijk de nuances van privacykwesties te verkennen, samen met betrokken privacy officers van de instellingen.

Data verzamelen en aanleveren

Verder werd er gezamenlijk gewerkt aan het verkrijgen van de benodigde data en de ontwikkeling van het dashboard zelf. De betrokkenheid van alle deelnemende instellingen zorgde voor een gedeelde visie en een gezamenlijke inspanning om het project tot een succes te maken.

In eerste instantie was het idee om de PoC met daadwerkelijke (persoons)gegevens uit te voeren, maar is gedurende de PoC besloten een eerste onderzoek te focussen op synthetische data vanuit de instellingen.

Technische opzet tijdens de PoC-fase

Voor dit project hebben we besloten om Kubernetes te gebruiken. Een essentieel aspect was de samenwerking met de leverancier van Ralph, een Learning Record Store (LRS). Deze leverancier is France Université Numérique (FUN), die een Helm-chart had ontwikkeld om Ralph te installeren op Kubernetes.

Een van de aspecten van ons ontwerp was het evalueren van de mogelijkheid om beschikbare data uit de informatiesystemen van de instellingen te transformeren naar de xAPI-standaard. Tijdens de PoC bleek dit goed haalbaar te zijn. Zelfs potentiële struikelblokken konden succesvol worden 'omgedacht' richting xAPI.

Het uiteindelijke ontwerp omvatte het opslaan van de getransformeerde xAPI-gegevens met behulp van Ralph en Elasticsearch. Deze gegevens werden vervolgens toegankelijk gemaakt voor de frontend/dashboard via standaard dashboarding tools en een API. Hiervoor zijn in een eerder stadium Grafana, en later Apache Superset als dashboardingtools onderzocht.

Lees meer over de technische opzet en bevindingen in het evaluatierapport.

Randvoorwaarden

De randvoorwaarden voor de technische infrastructuur zijn alsvolgt bepaald:

- Open source: waar mogelijk wordt gebruik gemaakt van bestaande en Open Source libraries, componenten en toepassingen.

- Ontkoppeld: componenten zijn loosely coupled en kunnen onafhankelijk van elkaar werken en zijn als modules te configureren.

- Voorwaarden: de gebruikte onderdelen zijn voor zowel SURF als de leden van SURF tegen dezelfde voorwaarden beschikbaar.

- Platform agnostisch: de gebruikte onderdelen zijn niet gekoppeld aan onderliggende infrastructuur. De gebruiker heeft vrije keuze voor installatie in het eigen datacenter, bij een leverancier of op een publieke cloud platform.

- Maatwerk: er wordt geen maatwerk ontwikkeld, met uitzondering van ‘plugins’ of ‘helpers’ om onderdelen aan elkaar te koppelen. Bijvoorbeeld voor het koppelen van een bronsysteem aan het LRS.

- Redundantie: met de geselecteerde software kan in de toekomst een High Availability architectuur worden opgebouwd.

- Open standaarden: scripts, recepten en modellen kunnen eenvoudig worden gedeeld.

- Schaalbaar: bij toename van de hoeveelheid data, analyses en visualisaties kan er zowel horizontaal als verticaal worden opgeschaald.

Bevindingen vanuit instellingen

Na afloop van de PoC zijn gesprekken gevoerd met 5 van de 6 deelnemende instellingen. Hieronder bespreken we een paar punten die daaruit naar voren kwamen. Er zijn ook verschillende verbeterpunten genoemd, van klein tot groot. In het evaluatierapport is dit vollediger en in meer detail behandeld.

Belang van een gezamenlijke LA-infrastructuur

Vrijwel alle instellingen zijn van mening dat werken aan een landelijke learning analytics omgeving belangrijk is. Een van de geïnterviewden zegt daarover:

“Het is belangrijk dat een landelijke infrastructuur om met LA aan de slag te gaan met instellingen verkend wordt. Veel instellingen worstelen namelijk op dit vlak. Ze willen wel aan de slag met LA, maar weten niet waar te beginnen. Een technische infrastructuur ontbreekt. Die landelijke focus is belangrijk”.

Een vervolg om een landelijke infrastructuur verder te verkennen en te ontwikkelen wordt positief ontvangen en de meeste instellingen overwegen deelname aan een vervolg (experimenteren met learning analytics op een door SURF te ontwikkelen generieke infrastructuur).

Samenwerking met SURF

Over de samenwerking met SURF zijn alle geïnterviewden positief. De samenwerking is ervaren als prettig en het team als behulpzaam. Vooral de expertise op het vlak van techniek en data wordt geprezen. Er is steeds goed omgegaan met feedback van de instellingen, er is echt wat mee gedaan; dingen zijn aangepast. Dat is als prettig ervaren.

Wel wordt in de gesprekken aangegeven dat het wat kwetsbaar is dat vooral de technische expertise bij één persoon lag. Voor een vervolg zou meer ontwikkelkracht, in plaats van één persoon, nodig zijn. Dit wordt dan ook voor de pilotfase meegenomen in de plannen.

Wat leverde het op?

Drie van de geïnterviewde instellingen geven aan dat zij door de PoC een intern proces hebben doorlopen dat leerzaam was. Door deelname aan de PoC was er een concrete aanleiding om binnen de instelling data te verzamelen en werd het nodig om gesprekken te voeren met privacy officers en management. Dit te doorlopen proces was nuttig en heeft leerpunten opgeleverd:

- Inzicht in hoe ver verschillende instellingen zijn met het inbedden van LA.

- Het verzamelen van data en toegang krijgen tot de data voor learning analytics is voor de meeste instellingen geen sinecure. Bij een van de instellingen bleken de data helemaal niet gebruikt te kunnen worden: “Het delen van echte LMS- en/of SIS-gegevens met SURF zou te lang hebben geduurd om te regelen, daarom hebben we ervoor gekozen om een fictieve dataset te delen”.

- Inzicht in de haalbaarheid van learning analytics binnen de instelling, op dit moment: “Momenteel is de cultuur met betrekking tot learning analytics en het gebruik van studentgegevens op onze instelling niet volwassen genoeg om data-geïnformeerd te werken, wat het ook moeilijk maakt om gegevens met anderen te delen”.

“Door de PoC te doorlopen is onze instelling echt klaar voor de volgende stappen met learning analytics”

De PoC heeft laten zien wat de mogelijkheden zijn. Bijvoorbeeld dat een LRS kan werken en dat er alternatieve tools zijn voor visualisatie dan de huidige binnen de instelling gebruikte tools. Toch zijn niet alle instellingen van plan de lijn van de PoC verder te volgen:

“Er is inspiratie opgedaan met het LRS en met tooling zoals Apache Superset, dat houden we in ons achterhoofd. Een LRS, zoals in de PoC gebruikt, zou niet iets zijn dat we zouden gebruiken, omdat er andere technische oplossingen zijn die volgens ons beter werken, maar het was inzichtelijk om te zien wat er mogelijk zou zijn. “

Rol van privacy officers

Het begrip van learning analytics onder privacy officers is van groot belang om een succesvol learning analytics project te kunnen draaien. SURF heeft daarom ook een aparte sessie voor privacy officers georganiseerd. Deze bijeenkomst werd gewaardeerd. Bij een van de instellingen is het begrip over learning analytics bij de FG en PO daardoor echt toegenomen wat het project ten goede kwam. Bij een andere instelling is naar aanleiding van deze PoC een privacy officer aan het learning analytics team toegevoegd.

“We willen graag doorgaan/blijven werken aan LA-gerelateerde projecten met SURF”.

Uitdagingen

Er komen enkele cruciale uitdagingen naar voren die de voortgang van ons project binnen instellingen hebben beïnvloed. Deze struikelblokken kunnen als volgt worden samengevat:

- Data-acquisitie binnen instellingen: Het verwerven van relevante data binnen instellingen blijkt lastig. Het ontsluiten van deze informatie lijkt een complexe taak, waarbij toegang tot de benodigde gegevens bemoeilijkt wordt.

- Betrokkenheid van instellingen: ondanks de aanstelling van projectleiders binnen instellingen, heeft een dergelijk project lagere prioriteit en daarmee betrokkenheid. Om dit thema van de grond te krijgen is het van belang dat concrete meerwaarde door interne stakeholders zichtbaar is. Een gebrek hierin, alsook gebrek aan tijd, resulteert in het vertragen van vooruitgang en inzet die vereist zijn.

- Urgentieproblematiek: het is een uitdaging om een gevoel van urgentie te creëren bij alle instellingen wanneer er onderzocht wordt middels één generieke use-case. Deze lijkt niet adequaat te zijn om consensus te bereiken en deelnemers naar een gedeelde visie te leiden.

- Verwachtingen liepen uiteen: de doelen, en verschil, tussen Proof of Concept en de Experimenteeromgeving waren niet voor eenieder even duidelijk. Het dashboard voor studenten suggereert inhoudelijke tests, terwijl de Experimenteeromgeving zelf een meer technisch doel dient en als middel gebruikt kan worden.

Het vergroten van de betrokkenheid, het verduidelijken van verwachtingen en het scherpstellen van de focus zijn essentiële stappen om het project op koers te houden. Hieraan besteden we in de pilotfase aandacht!

Vervolgstappen: van PoC naar pilotfase

In de huidige status is de omgeving nog niet op het gewenste niveau. In het evaluatierapport zijn verschillende (technische) aandachtspunten opgenomen.

Om het ontwerp van het systeem grondig te onderzoeken is het noodzakelijk specifieke use-cases uit te voeren in samenwerking met instellingen. Deze use-cases zullen dienen als cruciale tests om te waarborgen dat het systeem optimaal presteert in situaties die overeenkomen met het verwachte gebruik. Deze tests bieden inzicht in de praktische toepassing van het ontwerp en identificeren eventuele zwakke punten die moeten worden aangepakt.

Experimenten met instellingen: pilotfase

Om de learning-analytics-omgeving samen verder te onderzoeken en te ontwikkelen biedt SURF/Npuls een aantal instellingen de kans om onder begeleiding experimenten met studiedata te organiseren en faciliteren met de experimenteeromgeving, die op basis van de wensen en behoeften van de instellingen verder wordt ontwikkeld. Daarmee gaan we van PoC-fase naar pilotfase.

Doelen van de pilotfase

- Het doel van deze nieuwe fase is om met experimenten de technische infrastructuur voor learning analytics (verder) te ontwikkelen. Dat willen we graag doen met concrete use-cases vanuit onderwijsinstellingen. Het projectteam zoekt daarvoor in ieder geval drie instellingen om mee te doen, om vanuit een concrete vraag te komen tot een uitgewerkt eindresultaat middels de experimenteeromgeving.

- Een technische omgeving waarin data vanuit verschillende bronnen ingeladen kan worden. Deze is getest met synthetische data, maar zal nog verder moeten worden ontwikkeld om zodoende volledig te voldoen aan de privacy- en security voorwaarden die gelden bij experimenten met persoonsgegevens. Deze omgeving kan de data uit verschillende bronsystemen vertalen naar een standaard datamodel om op die manier onafhankelijk van de bronsystemen die bij instellingen actief zijn analyses kunnen worden gedaan.

- Drie afgeronde learning analytics experimenten bij drie instellingen met behulp van de experimenteeromgeving die SURF ontwikkelt, op basis van de behoefte van de deelnemende instellingen. In 2024 willen we met de experimenteeromgeving minstens één experiment op basis van een use-case van een instelling afronden en de overige twee instellingen vóór 1 juli 2025.

Heeft jouw instelling een use-case waarmee je wilt experimenteren?

De call voor de use-cases voor de experimenten is hier te vinden.

0 Praat mee