Duuk Baten

Digitale innovatie voor onderwijs en onderzoek. Nu ben ik binnen SURF bezig… Meer over Duuk Baten

In juni 2023 heeft het Europees Parlement (EP) ingestemd met een voorstel voor de aankomende AI-verordening (AI Act) en daarmee is ook het EP nu tot een conclusie gekomen rondom de regulering van AI. De EP was als derde aan de beurt, na de Europese Commissie en de Raad van Ministers. Dit betekent dat de Commissie, Raad van Ministers en het EP nu de langverwachte onderhandelingsfase (de zogenoemde ‘trilogue’) ingaan met als doel de drie voorstellen samen te voegen en te komen tot een definitieve wetstekst.

Note: Deze blog is geschreven voor het NPuls magazine Slimmer Onderwijs met AI in de zomer van 2023. Dit betekend dat deze niet up-to-date is met de recente ontwikkelingen rondom de goedkeuring van de AI act door de EU.

Wat je hieronder leest is een verzameld inzicht over de AI Act tot nu toe, maar kan, zolang de AI Act nog niet is goedgekeurd, geen zekerheid bieden. Voor vragen raden we je aan contact op te nemen met je eigen juridische afdeling.

Een korte historie:

De AI Act in het (super) kort:

Wat staat er dan beschreven de AI Act?

Heel kort gezegd is de EU AI Act een wet die zorgdraagt voor veilige en verantwoordelijke AI door het beperken en beheersen van de risico’s van AI. In de basis is het een product regulering, dat wil zeggen dat het primair is ge- richt op ontwikkeling en toepassingen van AI in plaats van de technologie in z’n algemeen.

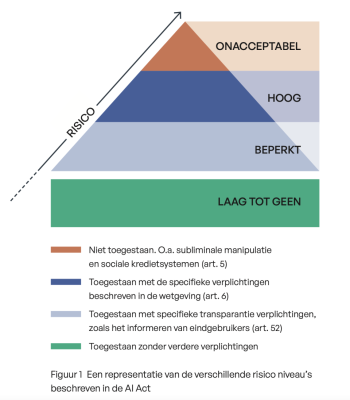

De AI Act is gebaseerd op risicoprofielen van verschillen- de AI-toepassingen, afhankelijk van de risico’s worden AI systemen gezien als onacceptabel (dan is het simpelweg verboden), hoog risico, en laag. Daarnaast is er nog een categorie toepassingen met specifieke transparantievereisten. Deze risico-classificatie bepaalt welke eisen en regels van toepassing zijn voor aanbieders (waaronder ontwikkelaars), distributeurs, importeurs of gebruikers. Als laatste zijn er de overgebleven toepassingen die als laag tot geen risico gezien worden en niet door de AI act worden gereguleerd.

Verplichtingen voor AI in het onderwijs

De AI Act spreekt ook specifiek over het onderwijs en heeft een aantal specifieke artikelen rondom de toepassing van AI in het onderwijs opgenomen. Dit volgens de EU omdat AI systemen in het onderwijs significante impact kunnen hebben op de levensloop van mensen en hun mogelijkheden om in hun eigen levensonderhoud te voorzien. Daarom zouden slecht ontworpen AI toepassingen mogelijk het recht op onderwijs en het recht op non-discriminatie kunnen schenden (beschreven in de overweging/recital 35).

Art 5 (verboden toepassingen): Een verbod op het in de markt plaatsen of gebruiken van AI om emoties te detecteren binnen onder andere de werkomgeving en onderwijsinstellingen.

Art 6 (hoog risico toepassingen):

Hoe deze precies in de uiteindelijke wetgeving terecht komen is nog onduidelijk, want er zijn verschillende interpretaties beschreven in de drie verschillende concept-teksten. Maar duidelijk is dat het gebruik van AI in onderwijs door de AI Act gereguleerd gaat worden.

Wat zijn dan de verplichtingen?

De meeste regels en verplichtingen gelden voor de hoog risico categorie (beschreven in hoofdstuk 2 van de wetstekst). Bij het aanbieden en ontwikkelen moet je denken aan onder meer regels en verplichtingen rond het hebben van risico- en kwaliteitsmanagement-systemen voor AI en gedurende de levensduur van de AI, kwaliteit van data(sets), technische documentatie, transparantie over de AI, het verstrekken van informatie aan gebruikers (ook door het verstrekken van gebruiksinstructies), het (laten) uitvoeren van een conformiteitsassessment en het registreren van de AI in een EU AI product database. Deze eisen lijken sterk op de eisen die gelden voor het op de markt brengen van producten (incl. het hebben van een verklaring van conformiteit en een CE-markeringen voor bepaalde AI).

Als gebruiker van hoog risico AI (bijvoorbeeld een instelling die een systeem inkoopt ten behoeve van onderwijs of voor bedrijfsvoering) ben je verantwoordelijk voor het volgen van de instructies van de aanbieders, menselijk toezicht met voldoende expertise en autoriteit, verantwoordelijk voor de relevantie en kwaliteit van de input-data en dien je voor de AI een fundamental rights impact assessment uit te voeren. Daarnaast gelden ook voor distributeurs en importeurs bepaalde verplichtingen, al zijn deze niet zo uitgebreid.

Of al deze regels en verplichtingen in deze vorm de eindstreep halen is nog onduidelijk evenals hoe dit in de praktijk gaat werken. Wat wel duidelijk is, is dat het onderwijsinstellingen niet om de AI Act heen kunnen en dat een aantal potentieel belangrijke toepassingen worden geraakt door regels en verplichtingen voor hoog risico AI.

Het is daarnaast belangrijk te beseffen dat naast de AI Act, ook de AVG van toepassing is als de AI gebruikmaakt van persoonsgegevens (bijv. voor het trainen en ontwikkelen van een model). De AVG is bovendien van toepassing ongeacht de risico-classificatie van de AI (hoog, beperkt, of laag risico).

En nu?

De verwachting (hoop) is dat in het begin van het nieuwe jaar de definitieve tekst van de AI Act wordt goedgekeurd. Vanaf die dag geldt een periode van 2 jaar tot inwerkingtreding. Dat geeft ook instellingen een periode van 2 jaar voor het precies bepalen van de impact van de AI Act en het implementeren hiervan binnen de eigen organisatie. Onze inschatting is dat die voorbereidingstijd ook hard nodig is gelet op alle veranderingen rond met name de ontwikkeling en gebruik van hoog risico AI. Na deze 2 jaar is de AI Act van kracht en kunnen toezichthouders deze handhaven.

Relevante achtergrond informatie:

Digitale innovatie voor onderwijs en onderzoek. Nu ben ik binnen SURF bezig… Meer over Duuk Baten

0 Praat mee