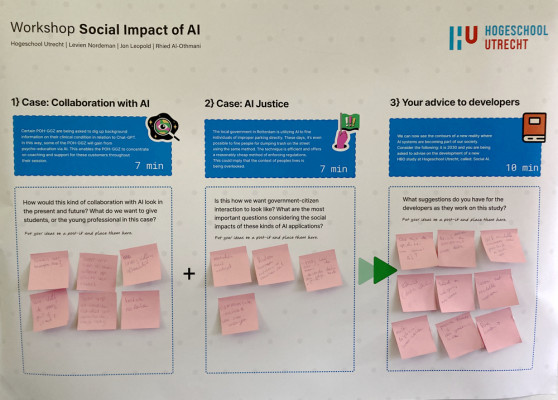

Casus 1: Samenwerken met AI

AI ontwikkelt zich in een snel tempo. Dit brengt ons op een punt waar mensen beginnen

applicaties te integreren in hun werkprocessen. Een voorbeeld: een collega van ons werkt

als POH-GGZ. Dit is iemand die zich richt op geestelijke gezondheidsproblemen samen met

een huisarts. In dit werkveld is het niet vanzelfsprekend om iemand door te verwijzen naar

een chatbot, omdat menselijk contact belangrijk is voor de behandeling. Maar wat er nu

gebeurt is dat specifieke cliënten (die beoordeeld zijn als bekwaam hiervoor) gevraagd

wordt om achtergrondinformatie over hun klinisch beeld in relatie tot Chat GPT op te

zoeken. Op deze manier kunnen een deel van zijn cliënten psycho-educatie krijgen door

gebruik te maken van AI. Dit geeft de POH-GGZ ruimte in zijn afspraak met deze cliënten

om zich te richten op ondersteuning en coaching. Tegelijkertijd neemt het een vrij

repetitief deel van zijn werk weg. Dit is een voorbeeld van hoe AI kan helpen in het domein

van geestelijke gezondheid.

Vraag: Hoe zou deze vorm van samenwerking met AI er nu en in de toekomst uitzien? Wat willen we studenten en jonge professionals bieden?

De juiste toon vinden

De deelnemers hebben verschillende reacties op de casus. Allereerst gaat het over de

manier van communiceren. Sommige deelnemers noemen het gebruik van Chat GPT

onpersoonlijk en zakelijk. 'Je kunt niet tussen de regels lezen', stelt iemand. De toon, de

intonatie die een zorgverlener wél heeft, ontbreekt als je alles van een scherm leest. De

deelnemers gaven ook aan dat de vragen (de prompts) en vooral wie deze vragen stelt

(experts of leek?) van belang zijn. Hier moet kritisch over nagedacht worden. Ook werd er

gesproken over het menselijk aspect: toont de chatbot voldoende emotie en empathie?

Waarom geen folder meegeven?

Er is ook een kans dat er foutieve informatie wordt gedeeld, stellen een aantal deelnemers.

Daarnaast is er een aanvullende check nodig nadat deze informatie wordt verkregen door

tools als ChatGPT. Belangrijke hierbij is of de informatie recent is, en hoe betrouwbaar de

informatie is. Of zoals een participant zei: ‘waarom geen folder meegeven? Een

veelgenoemd nadeel: je weet niet waar 'ChatGPT mee gevuld is', dus hoe kun je weten of de

informatie klopt?

De vragen richten zich dus enerzijds op de kwaliteit van dienstverlening, is deze

voldoende en kunnen we daarop vertrouwen? Anderzijds worden er vragen gesteld over of

systemen als deze niet te exclusief zijn. Wie is talig genoeg? Wie weet de juiste vragen te

stellen om tot zinvolle antwoorden te komen? Creëren we dus niet nieuwe digitale kloven

met de inzet van deze technologie?

Casus 2: AI en rechtvaardigheid

In Rotterdam maakt de lokale overheid met succes gebruik van AI om mensen die verkeerd

parkeren direct te beboeten. Deze methode wordt nu ook gebruikt om mensen te

beboeten die hun afval verkeerd op straat plaatsen. Het systeem is effectief en

introduceert een relatief goedkope manier om regels met betrekking tot afvalplaatsing te

handhaven. Maar wat gebeurt er wanneer onze systemen en instellingen gegevens,

algoritmen en AI gebruiken om hun interacties met burgers te optimaliseren? Men zou

kunnen betogen dat dit systeem rechtvaardig is omdat het mensen als gelijken behandelt.

Maar een ambtenaar die vroeger gewoon aanbelde bij burgers en zo zicht kreeg op de

specifieke levenssituatie, is niet meer betrokken is bij het besluitvormingsproces. Dit

betekent bijvoorbeeld dat mensen die al 200 rekeningen hebben open staan nog steeds

automatisch een nieuwe zullen ontvangen. Wat betekent dit voor de relatie tussen

overheid en burger en de onderverdeling van burgers?

Vraag: Willen we dat de interactie tussen overheid en burger er zo uitziet? Wat zijn hierbij de

belangrijkste vragen met betrekking tot de maatschappelijke impact van dit soort AI-

toepassingen?

De kloof tussen burger en overheid

Deze casus roept zorgen op bij de deelnemers. Hoe behouden we de menselijke maat? Men

vraagt zicht af of deze Big-Brother surveillance niet juist onveiligheid in de hand werkt. En

zijn er met het gebruikt van big-data door de overheid ook al verschillende voorbeelden

bekend waarin de procedure eerder discriminerend en onrechtvaardig bleek te zijn?

Gevreesd wordt dat de kloof tussen burgers en overheid zal toenemen door de inzet van

deze systemen. ‘Iedereen wordt in dezelfde mal gestopt, maar iedereen is anders’, zegt een

deelnemer. Anderen benoemen dat jij als burger door deze AI-systemen juist ook

gekleineerd kan gaan voelen.

Andere deelnemers zien in deze casus de contouren van een surveillance

maatschappij. Onder andere Big Brother en tv-programma's als Arcadia en Hunted worden

genoemd. Maar er zijn ook andere perspectieven. Zo zegt een deelnemer: dit systeem geeft

orde, iedereen weet hierdoor wat de grens is.

Ongelijke behandeling

Ook onderwerpen als privacy, AVG en databescherming komen aan de orde bij de

bespreking van casus 2. Hoe kunnen we zo’n systeem inzetten zonder direct te straffen,

maar eerst waarschuwen? Een aantal deelnemers vraagt: wat is eigenlijk het achterliggende

probleem? Ook function creep wordt genoemd als mogelijk risico: de camera's zouden ook

voor andere doeleinden gebruikt kunnen worden. Dan is de vraag: wie 'stuurt' de camera's

een bepaalde wijk in? Er is een kans op 'goede' en 'slechte' wijken. Of deze situatie tot

gelijke of juist minder gelijke behandeling leidt, hangt af van de parameters die je gebruikt,

en die zijn uiteindelijk weer door mensen ingesteld, aldus een deelnemer.

Een ander aspect is hoe de resultaten van AI-systemen gecommuniceerd worden

met burgers. Zulke system maken fouten, stelt een aantal deelnemers. En er kan ook bias

ontstaan, maar dat zien we bij mensen ook gebeuren, in de vorm van ‘verkeerd profileren’.

Een deelnemer ziet het systeem als een stoplicht: dat is ook rechtvaardig, en neemt de

context mee. Het kan ook juist ruzies voorkomen.

Casus 3: Een nieuwe studie in 2030: Sociale AI

We kunnen nu de contouren zien van een nieuwe realiteit waarin AI-systemen deel

uitmaken van onze samenleving. Stel je het volgende voor: het is 2030 en je wordt

gevraagd advies te geven over de ontwikkeling van een nieuwe HBO-studie aan de

Hogeschool Utrecht, genaamd: Sociale AI.

Vraag: Welke suggesties je voor de ontwikkelaars die deze nieuwe HBO-studie aan het

ontwikkelen zijn?

Niet in hokjes denken

Kennis van techniek en digitale ethiek is volgens de deelnemers aan de workshop erg

belangrijk. “Human-centerend AI = ethiek!”, schreef iemand op de post-it. Het gaat niet

alleen over ethiek, maar ook over kritisch en transparant omgaan met data. Hierbij geven de deelnemers aan dat studenten zelf met modellen aan de slag moeten gaan, en hands on aan de slag gaan met de technologie. We moeten studenten niet alleen technische aspect

meegeven, maar ook vragen rondom duurzaamheid, communicatie, en het leren niet in

hokjes te denken.

Andere deelnemers vinden het belangrijk om aandacht te besteden aan de rol van

de mens. Kennis hebben van positieve psychologie is volgens een deelnemer ook belangrijk: hoe kun je bepaald gedrag juist stimuleren? Een deelnemer aan de workshop stelt een excursie naar China voor, om zo de controlestaat te 'beleven'. Ook het transparant maken van de 'Black Box' van AI wordt genoemd. Studenten zouden zich ook moeten kunnen specialiseren in specifieke richtingen, zo wordt genoemd. Neem de stem van studenten serieus, stellen deelnemers. Zorg dat studenten interdisciplinair gaan werken en leren en leren in scenario’s te denken.

Wetgeving en kritisch nadenken

De deelnemers aan de workshop vinden dat beleid en wetgeving rond AI wordt

meegenomen in het ontwikkelen van de nieuwe HBO-studie Social AI. Toekomstige

professionals zullen uitgerust moeten worden met specifieke vaardigheden: je zult de juiste

vragen moeten stellen, de wisselwerking tussen mensen en AI bepaalt immers de output.

Zelfstandig kritisch nadenken wordt nog belangrijker wanneer het gaat om het interpreteren van informatie en zicht te krijgen op de verschillende belangen die meespelen bij technologie.

Daarnaast zullen er maatschappelijk en sociale gevolgen zitten aan de inzet van AI.

Wanneer AI dé oplossing wordt voor een bepaald probleem, dan moet een professional de

vaardigheden ontwikkelen om de negatieve effecten van deze AI-toepassing op de

samenleving te kunnen verminderen. Deelnemers hopen dat de ontwikkelaars van deze

nieuw HBO-studie de studenten meegeven dat AI een middel is en geen doel op zich. Dit

betekent dat we het niet moeten inzetten omdat het kan of een hype is, maar dat we

kritisch kijken naar wat het toevoegt en ten dienste van welk doel of waarde het ingezet

wordt.

Belangrijke inzichten

Er zijn een aantal thema's rondom de maatschappelijke impact van AI zichtbaar in de

reacties van de HU-medewerkers tijdens de workshop. Deelnemers benadrukken het belang van menselijk contact, emotie en empathie wanneer er AI-systemen worden ingezet. Een ander thema is de kwaliteit van informatie: hoe weet je of ChatGPT de juiste informatie geeft als we deze AI-technologie inzetten in de gezondheidszorg of voor overheidstaken? Als derde thema zien we dat deelnemers vragen stellen bij de gevolgen voor burgers van beslissingen die AI-systemen nemen. Hoe zorg je ervoor dat dit rechtvaardig gebeurt? Hoe voorkom je bias en discriminatie? Een laatste thema die in de casussen naar voren komt zijn de vaardigheden die huidige en toekomstige professionals zouden moeten ontwikkelen om met AI-technologie om te kunnen gaan. Kritisch kijken naar toevoegde waarde, vragen stellen en zelfstandig nadenken zijn daarbij erg belangrijk.

English version:

HBO employees on the social impact of AI

Workshop results during the Research and Education Festival

Hogeschool Utrecht - April 13, 2023

The rise of ChatGPT shows how AI is intervening in our daily lives and education. But AI is

more than ChatGPT: from search engines to facial recognition in your phone, data and

algorithms are changing the lives of our students and their future field of work. What does

this mean for the programs we work for? For the inspiration session The Social Impact of AI

during the HU Education Festival 2023, we invited our colleagues to join us in thinking about recent AI developments. We looked not only at the technology but specifically at the social impact and what the opportunities and threats of AI are for an open, just and sustainable society. We conducted conversations with our colleagues (faculty and staff from different departments) using three case studies. The collected results and insights from these conversations were compiled on a specially developed poster for the workshop.

We have summarized these insights and they can be read below.

Case study 1: Collaborating with AI

AI is developing at a rapid pace. This brings us to a point where people are starting to

integrate applications into their work processes. As an example, a colleague of ours works

as a POH-GGZ. This is someone who focuses on mental health problems together with a

general practitioner. In this field of work, it is not natural to refer someone to a chatbot,

because human contact is important for treatment. But what happens now is that specific

clients (who are assessed as competent for this) are asked to look up background

information about their clinical situation in relation to Chat GPT. In this way, some of his

clients can get psycho-education using AI. This gives the POH-GGZ space in his

appointment with these clients to focus on support and coaching. At the same time, it

takes away a fairly repetitive part of his work. This is an example of how AI can help in the

mental health domain.

Question: What would this type of collaboration with AI look like now and in the future? What do we want to offer students and young professionals?

Finding the right tone

Participants have different reactions to the case study. First, it is about the way of

communicating. Some participants call the use of Chat GPT impersonal and businesslike.

'You can't read between the lines,' someone argues. 'The tone, the intonation that a

caregiver does have, is missing when you read everything from a screen.' The participants

also indicated that the questions (the prompts) and especially who asks these questions

(experts or laymen?) are important. This needs critical thinking. The human aspect was also discussed: does the chatbot show enough emotion and empathy?

Why not provide a leaflet?

There is also a chance that incorrect information will be shared, some participants stated. In addition, an additional check is needed after this information is obtained by tools such as ChatGPT. Important here is whether the information is recent, and how reliable the

information is. Or as one participant said, "why not give a leaflet with the information? A

frequently mentioned disadvantage: you don't know what 'ChatGPT is filled with', so how

can you know if the information is correct?

So on the one hand, the questions focus on the quality of service, is it sufficient and can we

trust it? On the other hand, questions are raised about whether systems like this are not too

exclusive. Who is linguistically adequate? Who knows how to ask the right questions to

arrive at meaningful answers? In this case, aren't we creating new digital divides with the

deployment of this technology?

Case study 2: AI and justice

In Rotterdam, local authorities are successfully using AI to directly fine people who park

incorrectly. This method is now also being used to fine people who misplace their trash on

the street. The system is effective and introduces a relatively inexpensive way to enforce

rules related to waste placement. But what happens when our systems and institutions

use data, algorithms and AI to optimize their interactions with citizens? One could argue

that this system is fair because it treats people as equals. But an official who used to

simply ring citizens' doorbells and gain insight into their specific life situation is no longer

involved in the decision-making process. This means, for example, that people who

already have 200 bills unpaid will still automatically receive a new one. What does this

mean for the government-citizen relationship and the subdivision of citizens?

Question: Do we want government-citizen interaction to look like this? What are the key questions here regarding the social impact of this type of AI application?

The gap between citizen and government

This case raised concerns among the participants. How do we maintain the human

dimension? One wonders whether this Big-Brother surveillance does not actually promote

insecurity. And with the use of big-data by the government, are there already several

examples where the procedure turned out to be discriminatory and unjust? It is feared that

the gap between citizens and government will widen with the use of these systems.

'Everyone is put in the same mould, but everyone is different,' says one participant. Others

mention that as a citizen you may feel belittled by these AI systems.

Other participants see in this case study the contours of a surveillance society. Big Brother

and TV programs such as Arcadia and Hunted, among others, are mentioned. But there are

also other perspectives. For example, one participant says: this system provides order,

everyone knows what the limit is because of this.

Unequal treatment

Issues such as privacy, GDPR and data protection also come up in the discussion of Case 2.

How can we deploy such a system without immediately punishing, but first warning? Some

participants ask: what is the actual underlying problem? Function creep is also mentioned as a possible risk: the cameras could also be used for other purposes. Then the question is: who 'sends' the cameras into a particular neighbourhood? There is a chance of 'good' and 'bad' neighbourhoods. Whether this situation leads to equal or less equal treatment depends on the parameters you use, which in turn are ultimately set by people, according to one participant.

Another aspect is how the results of AI systems are communicated to citizens. Such systems

make mistakes, argues several participants. And bias can also occur, but we see that

happening with humans as well, in the form of "misprofiling". One participant sees the

system as a traffic light: that is also fair and takes the context into account. It can also

actually prevent quarrels.

Case study 3: A new study in 2030: Social AI

We can now see the outlines of a new reality in which AI systems are part of our society.

Imagine the following: it is 2030 and you are asked to advise on the development of a new

HBO study at Utrecht University of Applied Sciences called: Social AI.

Question: What suggestions do you have for the developers who are developing this new HBO study?

Not thinking in boxes

Knowledge of technology and digital ethics is very important, according to workshop

participants. "Human-Centered AI = ethics!" someone wrote on the post-it. It is not only

about ethics, but also about handling data critically and transparently. Here, participants

indicated that students need to work with models themselves and get hands on with the

technology. We need to give students not only technical aspect, but also questions around

sustainability, communication, and learning not to think in boxes.

Other participants think it is important to pay attention to the role of people. According to

one participant, having knowledge of positive psychology is also important: how can you

stimulate certain behaviour? A workshop participant suggests an excursion to China to

"experience" the control state.

Making the 'Black Box' of AI transparent is also mentioned. Students should also be able to

specialize in specific directions, it is mentioned. Take student voice seriously, participants

argue. Get students to work and learn interdisciplinary and learn to think in scenarios.

Legislation and critical thinking

Workshop participants feel that policy and legislation around AI should be included in the

development of the new Social AI college course. Future professionals will have to be

equipped with specific skills: you will have to ask the right questions, after all, the interaction between people and AI determines the output. Independent critical thinking will become even more important when it comes to interpreting information and gaining insight into the various interests involved in technology.

In addition, there will be societal and social consequences to the use of AI when AI becomes

the solution to a particular problem, a professional must develop the skills to be able to

reduce the negative effects of this AI application on society. Participants hope that the

developers of this new college course will impart to students that AI is a means and not an

end. This means not deploying it because it can be done or is hype, but rather looking

critically at what it adds and in the service of what purpose or value it is deployed.

Key insights

Several themes surrounding the social impact of AI were evident in the responses from HU

employees during the workshop. Participants stress the importance of human contact,

emotion, and empathy when AI systems are deployed. Another theme is the quality of

information: how do you know if ChatGPT provides the right information when we deploy

this AI technology in healthcare or for government tasks? As a third theme, we see

participants questioning the impact on citizens of decisions made by AI systems. How do you make sure this is done fairly? How do you prevent bias and discrimination? A final theme that emerges in the case studies are the skills that current and future professionals should develop to deal with AI technology. Looking critically for added value, asking questions, and thinking independently are very important here.

0 Praat mee