This article is also available in English

Psychologisch advies

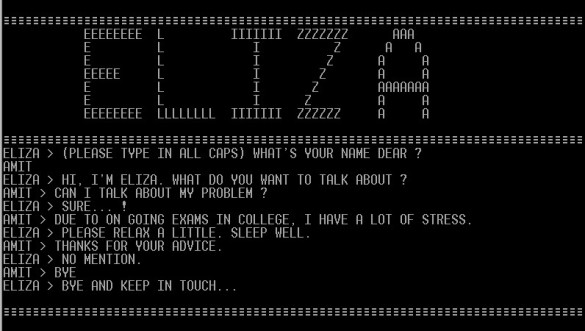

Het eerste computerprogramma dat gebruikmaakte van een heel elementair taalmodel, was Eliza. Dit programma werd ontwikkeld in 1966, al meer dan een halve eeuw geleden dus. Het was een chatbot die “psychologisch advies” gaf aan de gebruiker.

Eliza was het eerste programma dat natural language processing (NLP) toepaste. Het taalmodel dat aan de basis ligt van Eliza gebruikt patroonherkenning op basis van statistiek om antwoorden te genereren. Hoewel het een eenvoudig model is, kon Eliza de belangrijkste woorden uit de input herkennen en die gebruiken om een voorgeprogrammeerd antwoord te geven.

Chatbots

Tegenwoordig gebruiken we elke dag applicaties die met – gelukkig een stuk geavanceerdere – taalmodellen werken. Of je nou online winkelt of je banktegoed checkt, chatbots staan klaar om je erbij te helpen. Denk ook aan Google Translate, of de auto-aanvulfunctie die het typen op je telefoon makkelijker maakt. Uiteraard zijn er voorbeelden te over die laten zien dat dit soort applicaties nog niet perfect zijn. Maar ze worden wel steeds beter. Laten we eens kijken hoe ver ze al gekomen zijn.

Waar zijn taalmodellen toe in staat?

Welke taken kunnen taalmodellen uitvoeren die ons leven makkelijker maken? Een belangrijke functie is tekst classificeren. Door teksten in bijvoorbeeld teksten van klanten te interpreteren kan een programma bepalen of een tekst positief, neutraal of negatief van toon is. Zo’n sentiment-analyse wordt gebruikt om automatisch filmscores voor IMDB te generen, of productreviews op Amazon.

Machinevertaling is een andere bekende toepassing van taalmodellen. En machinevertaling lukt steeds beter. Was “Google Translate-vertaling” tot een jaar of vijf nog synoniem voor “zeer knullig vertaald stuk tekst”, de laatste jaren zijn computervertalingen zeer bruikbaar geworden. DeepL is een website die bijvoorbeeld ook zeer goede vertalingen oplevert en waaraan jaarlijks nieuwe talen worden toegevoegd.

Met taalmodellen kun je ook automatische samenvattingen maken en vragen beantwoorden. Dit laatste vormt de basis van de moderne chatbots.

Bij bijna alle hierboven genoemde taken genereert het computerprogramma tekst met behulp van een taalmodel. Om een goed antwoord of een goede samenvatting aan te bieden aan de gebruiker interpreteert het model diens input en vormt vervolgens nieuwe zinnen. Vorige taalmodellen konden al behoorlijk goede teksten genereren, maar ChatGPT brengt deze vaardigheid naar een veel hoger niveau. ChatGPT genereert zeer plausibele en coherente teksten omdat het getraind is op een immense hoeveelheid data. Het is eigenlijk een variant van GPT-3 die getraind is in een interactieve chatbot-omgeving. Daardoor kan ChatGPT gebruikersinput echt gebruiken om op basis daarvan nieuwe zinnen te genereren.

Een volgende stap in het toepassen van taalmodellen is het combineren van tekst en beeld. Recent werd DALL-E geïntroduceerd, een programma dat op basis van taalinput zelf een afbeelding genereert (zie hieronder).

De evolutie van taalmodellen

We hebben nu gezien wat taalmodellen kunnen, met de prestaties van ChatGPT als voorlopig hoogtepunt (hoewel daar wel iets op af te dingen is, waarover later meer). Maar hoe werken taalmodellen eigenlijk?

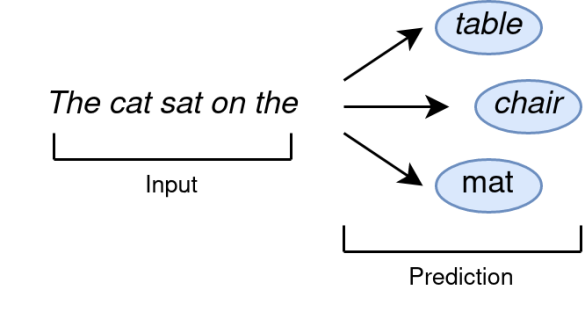

De basis voor de eerste taalmodellen was (en is nog steeds!) het voorspellen van het volgende woord in een zin. Het taalmodel houdt een "woordenboek" bij, dat voor een groot aantal woordcombinaties aangeeft hoe vaak ze voorkomen in de tekst waarmee het model getraind is. De computer berekent na elk woord opnieuw wat statistisch gezien het volgende woord moet zijn, dus welk woord het waarschijnlijkst volgt op het laatste woord. Hoe dit in de basis werkt zie je in de afbeelding hieronder, waar de zin “The cat sat on the mat” wordt gevormd:

Statistische modellen kunnen alleen zinnen genereren op basis van reeds bekende woordcombinaties, ze kunnen dus zelf geen nieuwe woordcombinaties maken.

Recurrent neural networks

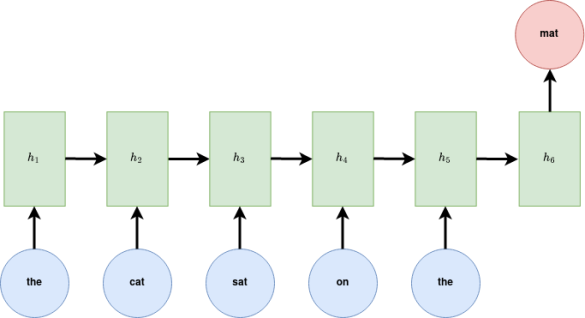

Later kwamen de eerste neurale netwerken, die krachtiger zijn dan de statistische taalmodellen, en belangrijker nog: ze kunnen patronen leren uit de data. Het doel van een neuraal netwerk was nog steeds om het volgende woord te voorspellen op basis van een gegeven input. De neurale netwerken die voor taal gebruikt worden, zijn recurrent neural networks, wat inhoudt dat ze een gegeven input parseren en hetgeen ze geleerd hebben weer gebruiken om het volgende woord te voorspellen. De kern daarvan is een verzameling parameters die getraind kunnen worden. Dat maakt dat deze neurale netwerken nieuwe woordcombinaties genereren op basis van de data.

De beperking is wel dat ze sequentieel werken: een gevonden woord wordt toegevoegd aan het resultaat, en dit nieuwe resultaat wordt weer door het model gehaald, enzovoort. Daardoor hebben woorden aan het begin van de zin minder invloed op een nieuw toegevoegd woord dan woorden verderop in de zin. In het voorbeeld hierboven: het woord sat zal meer invloed hebben op de keuze voor het woord mat dan het woord cat, omdat cat eerder in de zin voorkomt.

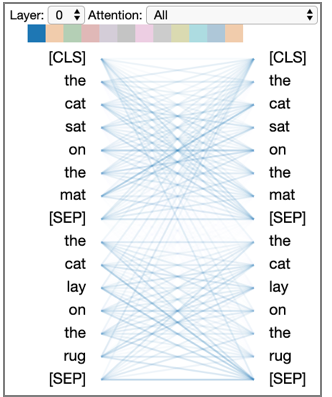

Sinds 2017 komt een nieuw type model-archtictectuur op, dezogenaamde Transformer. Deze nieuwe architectuur stelt het taalmodel in staat om zeer omvangrijk en krachtig te worden, waardoor deze modellen ook wel aangeduid worden met de term large language models (LLM). ChatGPT is daarvan een voorbeeld. Transformers kunnen tekstinput parallel verwerken:: ze kunnen alle woorden in een zin tegelijkertijd verwerken, in plaats van woord voor woord, zoals dat bij sequentiële modellen werkt. Daardoor zijn transformers veel sneller en kunnen ze meer data verwerken.

Transformers werken op basis van het concept attention: voor ieder woord uit de input leert het model hoezeer dit verwant is aan de andere woorden uit de input. Ze kijken bij het bepalen van het volgende woord naar de hele voorafgaande zin, terwijl sequentiële taalmodellen een weging uitvoeren: hoe verder een woord richting het eind van de zin staat, hoe meer een woord meeweegt in het bepalen van het volgende woord. Long term dependencies, oftewel relaties tussen woorden over grotere afstand in de zin, worden door Transformers dus beter meegenomen bij het bepalen van het volgende woord. Het bijhouden van eerdere woorden in de zin is essentieel bij het genereren van tekst, omdat de structuur en betekenis van de tekst als geheel coherent moeten zijn.

Miljarden parameters

Doordat er steeds meer rekenkracht beschikbaar is, hebben taalmodellen tegenwoordig miljarden parameters op basis waarvan ze nieuwe tekst kunnen genereren. In slechts twee jaar (tussen 2018 en 2020) zijn de state of the art taalmodellen meer dan vijfhonderd (!) keer groter geworden. Verder is er een bijna oneindige hoeveelheid data beschikbaar waarmee modellen getraind kunnen worden. Modellen kunnen daardoor steeds meer, wat ChatGPT bijvoorbeeld laat zien.

Risico’s

Dat de huidige generatie taalmodellen zoveel kunnen is natuurlijk heel mooi, maar dit heeft een schaduwzijde: de modellen zijn zo complex, dat we ze voorlopig als black boxes moeten zien. We hebben geen inzicht meer in de wijze waarop modellen precies tot hun output komen.

En dat brengt een aantal risico’s met zich mee, die we in de praktijk ook al zien. Een van die risico’s is bias, ofwel ongewenste voorkeuren voor onder andere ras, gender, leeftijd etc. Taalmodellen worden getraind met teksten op internet, en die teksten zijn vaak niet neutraal. Kijken we bijvoorbeeld naar hoe een getraind model naar gender kijkt bij vacaturebeschrijvingen, lijkt zo’n model vooroordelen te hebben tegen woorden als ontwikkelaar of chef. Tay, een chatbot die getraind is om met Twitter-gebruikers te communiceren, kwam in opspraak toen het beledigende en antisemitische content had getwitterd. Dit kwam voort uit de beledigende taal die door echte Twitter-gebruikers was aangeleverd als trainingdata.

Tay is ook een voorbeeld van misbruik van taalmodellen. De toenemende kans op gevallen van misbruik in academische en onderwijssettings is ook een heet hangijzer. Door taalmodellen gegenereerde teksten zijn nauwelijks meer te onderscheiden van teksten die door mensen zijn geschreven. Dat maakt het natuurlijk verleidelijk om bij het schrijven van scripties of artikelen de computer het werk te laten doen. Of om ChatGPT te gebruiken als de student een take-home examen maakt. Hoe houd je hiermee rekening bij het ontwerpen van huiswerkopgaven? En hoe weet je of je online waarheidsgetrouwe informatie vindt? Hoe wapen je je daartegen als docent?

Wat ook nog een probleem is, is de correctheid van de teksten die door taalmodellen worden gegenereerd. Taalmodellen kunnen zo geprogrammeerd worden dat ze grammaticaal correcte teksten opleveren, maar ze worden getraind met teksten die op internet staan. En wat op internet staat is niet per definitie waar. Dus er is altijd een risico dat een taalmodel een inhoudelijk niet-correcte tekst genereert. Daar moeten we bedacht op blijven, ook al lijkt ChatGPT zeer overtuigend. Een beroemd voorbeeld is dat waarbij ChatGPT "slechtvalk" antwoordt op de vraag "wat is het snelste zeezoogdier?"

De nabije toekomst van taalmodellen

In de afgelopen jaren zijn modellen steeds complexer geworden, en is er veel geld vrijgemaakt voor de rekenkracht om ze hun werk te laten doen. De komende jaren zal de nadruk blijven liggen op het vinden van het maximale vermogen van deze relatief nieuwe Transformers. Er zal ook onderzoek worden gedaan om dit te doen met grote hoeveelheden data van hoge kwaliteit en op een energiebesparende manier. Om de huidige generatie modellen goed te trainen, zullen immers steeds meer data nodig zijn. Modellen hebben tegenwoordig miljarden parameters, en het is een uitdaging om al die parameters van voldoende (domeinspecifieke) trainingsdata te voorzien. Bovendien kunnen is het trainen en hosten van dergelijke modellen vanwege hun omvang voorbehouden aan grote bedrijven zoals Google en Meta, waardoor zij veel invloed hebben.

Taalmodellen worden nu vooral ingezet om tekst te genereren, maar we zien al dat ze ook in andere domeinen hun waarde bewijzen: bijvoorbeeld door niet alleen tekst maar ook video en spraak te gebruiken als input voor taalmodellen, kunnen ze ook non-verbale uitingen verwerken, zoals ironie, maar denk ook aan gebarentaal. Dat maakt de mogelijkheden van taalmodellen nog veel uitgebreider. Taalmodellen kunnen ook worden "verfijnd" (d.w.z. verder getraind op zeer specifieke datasets) om ze beter te laten werken in specifieke domeinen, zoals het combineren van medische tekst met medische beelden, of het scannen en interpreteren van Middelnederlands.

Taalmodellen are here to stay

Het is duidelijk dat AI zich zal blijven ontwikkelen, en dat ook taalmodellen steeds geavanceerder worden. Ze zullen steeds meer kunnen. Laten we ons dus niet alleen richten op onze angst dat deze nieuwe modellen betere teksten zullen schrijven dan mensen, maar een realistische kijk ontwikkelen op hun potentieel en impact. Hoe kunnen taalmodellen ons ondersteunen om het onderwijs en onderzoek te verbeteren? Hoe zorgen we ervoor dat mensen en modellen elkaar aanvullen, in plaats van elkaar te beconcurreren? Daar liggende de grootste kansen.

Meer informatie

- Lees het blog van Duuk Baten, AI-specialist bij SURF, dat ingaat op de impact van taalmodellen op het onderwijs.

- Lees het blog van Erdinç Saçan over ChatGPT in het onderwijs

- Wil je meer weten? Mail naar thomas.vanosch@surf.nl of vivian.vanoijen@surf.nl. Voor algemene informatie mail je naar ai-info@surf.nl. Of kijk op www.surf.nl/ai.

Deze blog kwam tot stand met medewerking van Jan Michielsen en Vivian van Ooijen.

0 Praat mee