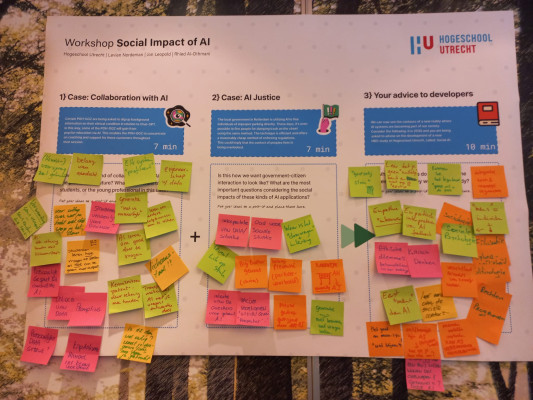

De workshop ‘De sociale impact van AI’ heeft als doel samen met HBO-medewerkers te reflecteren op de betekenis van AI-technologieën voor het onderwijs aan studenten. De deelnemers gaan in gesprek over drie casussen, waarbij de laatste specifiek over het HBO-onderwijs gaat. Na uitleg van de casus plakken de deelnemers post-its met hun reacties op een poster. Vervolgens bespreken wij als workshopleider de verschillende opmerkingen van de workshopdeelnemers. Tijdens de instituutsdagen van het Instituut voor People & Business van Hogeschool Utrecht gaven we de workshop tegelijkertijd aan twee groepen van ongeveer tien docenten. Hieronder reflecteren we op de inzichten uit de casussen en willen we laten zien wat voor HBO-medewerkers relevante thema’s rondom AI-technologie zijn.

Casus 1: Samenwerken met AI

Een collega van ons werkt als POH-GGZ. Dit is iemand die samen met de huisarts mensen ondersteunt met geestelijke gezondheidsproblemen. In de gezondheidszorg is het nog ongebruikelijk om patiënten naar een chatbot door te verwijzen, omdat menselijk contact belangrijk blijft voor de behandeling. Maar wat gebeurt er als specifieke cliënten (door de POH-GGZ geselecteerd) gevraagd wordt om achtergrondinformatie over hun psychische problematiek via ChatGPT op te zoeken (psycho-educatie). Hoe zou deze vorm van samenwerking met AI er nu en in de toekomst uitzien?

Persoonlijk contact is nog steeds belangrijk in de relatie tussen de POH en de patiënt, stellen een aantal deelnemers. Een van de deelnemers ziet de casus als een voorbeeld van een hellend vlak: tot hoever kun je gaan? Hoe voorkom je dat ‘mensen niet uitgefaseerd worden als we niet opletten'. Ook de kwaliteit van het AI-systeem is belangrijk, vinden de deelnemers: zou je het systeem kunnen leren om goed door te vragen bij een patiënt? En zou het systeem ook rekening kunnen houden met de lichaamstaal van een patiënt? Belangrijk is ook dat transparant wordt wat het AI-systeem met jouw gegevens doet. Privacy, regelgeving en protocollen daarom ook belangrijk.

Deelnemers zien voordelen van een AI-systeem voor psycho-educatie, zoals dat ChatGPT meerdere bronnen kan bieden en kan uitleggen welke aandoening iemand heeft. Het is belangrijk dat een dergelijk systeem ook rekening houdt met het kennisniveau van de patiënt. Deelnemers geven aan dat zulke tools als ChatGPT mensen goed kunnen helpen, vooral omdat de werkdruk in de zorg zo hoog is. Toch zijn er ook uitdagingen: wat als mensen niet zo taalvaardig zijn? Zijn AI-tools wel zo inclusief, bijvoorbeeld omdat zoals ChatGPT beter werken in het Engels. Het omgaan met dergelijke systemen vraagt dus ook om vaardigheden van patiënten, stellen deelnemers. Hoe schrijf je een goede ‘prompt’?

Casus 2: AI en rechtvaardigheid

In Rotterdam maakt de lokale overheid met succes gebruik van AI om mensen die verkeerd parkeren direct te beboeten. Deze methode wordt nu ook gebruikt om mensen te beboeten die hun afval verkeerd op straat plaatsen. Wat betekent dit voor de relatie tussen overheid en burger en de relaties tussen burgers? Willen we dat de interactie tussen overheid en burger er zo uitziet?

Wanneer een (lokale) overheid AI-systemen wil inzetten dan is het volgens een aantal deelnemers belangrijk om als overheid oog te blijven houden voor de leefsituatie van hun burgers: ‘waar is het doorvragen en het inleven?’ Andere deelnemers zien de inzet van AI-technologie door lokale overheden als iets waar een nieuwe generatie waarschijnlijk niet zoveel moeite mee heeft. Wel blijft het van belang om vragen te stellen, stellen ze. Sommige hebben moeite met de casus, zij zien een soort ‘Big Brother’ scenario waarbij de overheid net als in delen van China technologie gebruikt om burgers te controleren en te sturen. Wat is de intentie van de overheid bij het gebruik van AI?, vraagt een deelnemer zich af. En: ‘wat doet dit met vertrouwen in de overheid? En waar ligt de grens?’

Voorkomen moet worden dat er door de inzet van AI-technologie voor burgers geen perspectief meer is. Dat de technologie bepaalt wat hier goed of fout is, stellen de deelnemers. Als suggestie wordt het principe van de ‘human-in-the-loop' genoemd. De betrokkenheid en de uiteindelijke beslissingen blijven zo bij mensen moet en worden niet volledig overgelaten aan AI-systemen.

Casus 3: Een nieuwe studie in 2030: Sociale AI

Stel je het volgende voor: het is 2030 en je wordt gevraagd advies te geven over de ontwikkeling van een nieuwe HBO-studie aan de Hogeschool Utrecht, genaamd: Sociale AI. Welke suggesties je voor de ontwikkelaars die deze nieuwe HBO-studie aan het ontwikkelen zijn?

Vrijwel alle deelnemers zijn het met elkaar eens: in deze nieuwe opleiding zouden studenten vooral veel moeten leren over de mens. Net vaardigheden in programmeren, worden vakken als psychologie, sociologie, politicologie, rechten, ethiek en filosofie worden genoemd. ‘Eerst mens, dan AI’, schrijft een van de deelnemers op een post-it. Leer studenten dus over de sociale context van AI-systemen, vertellen de deelnemers. ‘Hoe bepaal je of AI sociaal is?’ De oplossing volgens een aantal deelnemers: zelf ook AI-toepassingen bouwen, binnen interdisciplinaire teams en vooral testen voordat de applicatie of systeem impact heeft op mensen. Juist dan zien studenten wat de sociale impact van AI is: ‘Leer studenten dat je geen “nulletje” bent en niet in je “eentje”’.

Deelnemers noemen ook het belang van empathie: hoe kun je empathie ‘inbouwen’ in systemen, en empathisch omgaan met de feedback die AI-systemen genereren? Andere deelnemers vragen zich af: ‘kunnen wij dit tegenhouden?’ AI-systemen lijken ‘griezelig slim’. Daarbij gaat het ook om de vraag wat het is om een mens te zijn. ‘Wat blijven wij?’ schrijft een deelnemer op een post-it. En hoe gaan we om met zelfbewuste AI? Dit zal wat doen met ons beeld van wie wij zijn, en heeft ook religieuze dimensies.

Conclusie

Deelnemers aan de workshop vinden het belangrijk dat studenten niet alleen technische vaardigheden hebben om AI-technologieën te gebruiken, maar ook in staat zijn om vragen te stellen over de sociale impact van AI. Een andere terugkerend thema is het vinden van een balans: AI-technologieën brengen efficiëntie met zich mee, maar we moeten ook nadenken over wat de gevolgen hiervan zijn voor mensen, voor bijvoorbeeld de relatie tussen burgers en overheden. Voor de deelnemers is kritisch denken over AI-technologie belangrijk. Een kritische houding kan voorkomen dat AI-systemen mensen uitsluiten, bijvoorbeeld door vooringenomenheid in de data die ze gebruiken. Als zulke AI-technologieën ingezet worden, dan moeten zowel studenten als docenten nadenken over de sociale impact daarvan. Voor het HBO-Onderwijs komen daarom nieuwe vragen centraal te staan, zoals: wat is sociaal? Wat is de mens? Binnen welke kaders werken en denken wij?

0 Praat mee