Anneke de Maat

Voor de website Vraagbaak Online Onderwijs schrijf en redigeer ik artikelen… Meer over Anneke de Maat

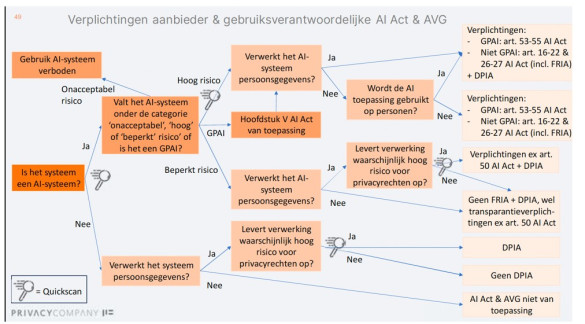

Als je ICT-systemen of AI in je onderwijs gebruikt, kan dat leiden tot het schenden van grondrechten, zoals bijvoorbeeld het grondrecht privacy. “Denk dus vooraf altijd na over de mogelijke risico’s”, benadrukte Niels Dutij in zijn workshop op de MBO Digitaal Conferentie. Hij gaf een kijkje in de praktijk en tips waar je op moet letten als je AI inzet in je onderwijs. Ook toonde hij een stroomschema dat helpt te bepalen wat je als onderwijsinstelling verplicht bent te doen.

Sinds 2018 is de Algemene Verordening Gegevensbescherming, de AVG, van kracht. Sinds februari 2025 is er ook de AI-Act die stapsgewijs ingevoerd wordt. Deze AI-verordening stelt regels aan het gebruik van AI-systemen op basis van risicoclassificatie. “Deze twee verordeningen van de EU bestaan naast elkaar en hebben overlap”, aldus Dutij. “Recht op transparantie is belangrijk in de AVG én in de AI Act.” Nationale toezichthouders gaan erop toezien dat het verbod op bepaalde AI-systemen en de eisen voor hoog-risico AI en transparantie worden nageleefd.

Dutij is cyberveiligheid-adviseur bij MBO Digitaal en vertelde dat MBO Digitaal in april 2025 met AI-richtlijnen komt. “Die beschrijven ook waar je op moet letten bij aankoop en gebruik van AI.” Dutij is eveneens Functionaris Gegevensbescherming (FG) bij verschillende mbo-instellingen. Als FG krijgt hij regelmatig vragen over AI, al is de FG toezichthouder op de AVG en niet noodzakelijkerwijs ook op de AI-Act. Hij ziet dat veel onderwijsinstellingen nog geen goed overzicht hebben van welke AI-tools er voor welke toepassing(en) gebruikt worden binnen hun school. Hij wees erop dat het belangrijk is het doel van de AI-inzet ofwel de toepassing te weten, “want dat bepaalt het risico.”

Sinds de invoering van de AVG hebben organisaties en bedrijven al te maken met de Data Protection Impact Assesment, kortweg ‘DPIA’ genoemd. Zo’n DPIA is verplicht als je organisatie van plan is persoonsgegevens te verwerken en dit een hoog privacy risico kan opleveren. Je moet dan de risico’s in kaart brengen en risico- verminderende maatregelen voorstellen.

Ook de AI-Act kent een risicobenadering en deelt AI-systemen in op basis van vijf risiconiveaus, liet Dutij zien. Dit zijn de vijf categorieën.

Als je als organisatie een hoog risico AI-systeem of AI-toepassing wilt inzetten, is het onder de AI Act nu verplicht om naast een DPIA ook een Fundamental Rights Impact Assessment (FRIA) te doen. Bij hoog risico gaat het over risico’s voor gezondheid, veiligheid of grondrechten (‘fundamental rights’).

Voorbeelden van hoog risico-toepassingen van AI in het onderwijs zijn:

Over de risicoclassificatie en de verplichtingen die voortkomen uit de AI-Act en wat dit voor onderwijsinstellingen betekent, kun je meer lezen in het gidsje ‘AI Act in het kort’ dat Npuls recent heeft gepubliceerd.

Het is goed te weten dat hoog risico AI-systemen verplichtingen met zich meebrengen voor zowel de aanbieders als de gebruikers. Afhankelijk van het type AI-systeem en wat de organisatie met dat AI-systeem doet gelden er eisen en verplichtingen. Veel scholen hebben nog geen goed overzicht van welke AI-systemen/tools er binnen de school gebruikt worden, ziet Dutij. Het is nu zaak dit te inventariseren en in kaart te brengen in welke risicocategorie de door de school gebruikte AI-systemen vallen.

De Gids AI-Verordening van de Rijksoverheid (oktober, 2024, versie 1.0) adviseert te inventariseren met de volgende vier stappen .

1. (Risico): Valt ons (AI-)systeem binnen één van de risicocategorieën?

2. (AI): Is ons systeem ‘AI’ volgens de AI-verordening?

3. (Rol): Zijn wij de aanbieder of gebruiksverantwoordelijke van het AI-systeem?

4. (Verplichtingen): Aan welke verplichtingen moeten wij ons houden?

Ook het stroomschema van Dutij [zie foto hieronder] kan je helpen bij het stapsgewijs in kaart brengen van de verplichtingen.

NB Het artikel gaat verder onder de foto...

Dutij vertelde tot slot over een praktijksituatie die hij meemaakte. Enkele mbo-scholen schaften een examenplatform aan waarmee ze mondelingen examens Engels kunnen afnemen. Dutij: “Studenten spreken de opdracht in. Het systeem beoordeelt puur op basis van spraak en geeft automatisch een score. Docenten en examinatoren krijgen alleen de uitslag. Ze hebben geen toegang tot het gemaakte examenwerk. De leverancier geeft geen toegang tot het examen in het systeem. Alleen de medewerkers van het examenplatform hebben de mogelijkheid een review te doen van het examen.”

Enkele scholen schaften het examensysteem aan zonder een DPIA te doen, terwijl het bij sommige scholen zelfs langs de examencommissie gegaan was. Dutij: “Ze kregen geen klachten, maar dat is niet verwonderlijk want het systeem deelt hoge cijfers uit.” In deze situatie moet echt een DPIA gedaan worden, benadrukte Dutij. “Er is sprake van het verwerken van persoonsgegevens en van geautomatiseerde besluitvorming.”

In dit examenplatform-praktijkvoorbeeld wordt ook AI gebruikt en zijn er verschillende risico’s aangaande grondrechten, vervolgde Dutij. “Toen die scholen het examensysteem aanschaften was de FRIA nog niet van kracht. Nu is in zo’n situatie als deze ook het doen van een FRIA verplicht, want je hebt hier te maken met grondrechten."

“Ten eerste het recht op gelijke behandeling. Zo’n AI-systeem kan bias (vooroordelen) bevatten, want iemand kan een accent of spraakstoornis hebben. Bij het tweede risico gaat het om de rechtmatigheid van gegevensverwerking. En bij het derde risico draait het om het recht op een eerlijk beoordelingsproces. De studenten kunnen hier de beoordeling zelf niet inzien. Ten vierde kan in deze casus ook het recht op transparantie niet gegarandeerd worden. Studenten en docenten hebben geen inzicht in hoe AI tot het cijfer komt. De examinator kan niet zelf in het systeem. Tot slot is er nog het risico van aansprakelijkheid. Het is niet duidelijk wie verantwoordelijk is bij fouten.”

Bedenk dus vooraf altijd wat mogelijke risico’s zijn als je met AI gaat werken, besloot Dutij. “En ga nooit werken met een AI-systeem omdat een andere school het ook al doet en het dus wel veilig zal zijn.”

Voor de website Vraagbaak Online Onderwijs schrijf en redigeer ik artikelen… Meer over Anneke de Maat

0 Praat mee